Il cervello delle macchine e il mistero del nostro: riflessioni sull’AI Assisi Act

ore

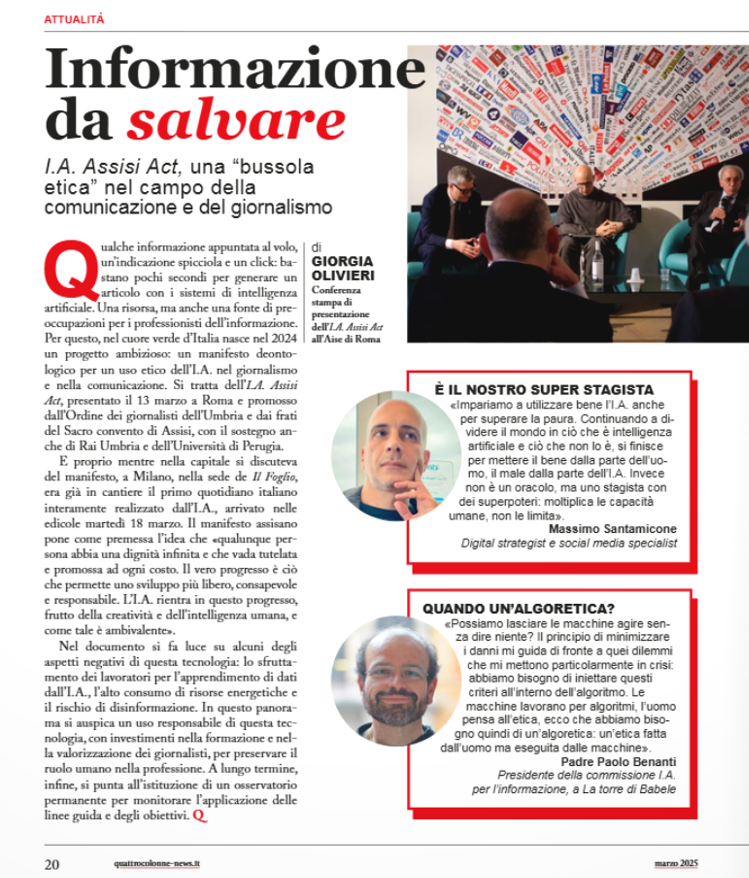

L’intelligenza artificiale sta smuovendo il mondo, trasformando ogni giorno professioni, relazioni e modi di vivere. E anche nella nostra Umbria qualcosa si muove: nei mesi scorsi è stato redatto e presentato l’AI Assisi Act, una dichiarazione etica sull’uso dell’IA nel giornalismo e nella comunicazione promossa dall’Ordine dei giornalisti dell’Umbria.

La “Dichiarazione di Assisi sull’Intelligenza Artificiale” firmata il 15 settembre 2024 è, prima di tutto, una dichiarazione d’intenti. Una presa di posizione importante, che dimostra come il mondo del giornalismo, dell’informazione, della comunicazione e della cultura sia consapevole della necessità di interrogarsi seriamente sull’impatto che l’IA sta già avendo e continuerà ad avere sulle nostre vite, sulle professioni e sulla società nel suo complesso. Ma come tutte le dichiarazioni d’intenti, anche questa rischia di rimanere un esercizio di stile se non sarà accompagnata da azioni concrete, strutturate e misurabili. Non bastano parole condivise e buone intenzioni: serve un osservatorio permanente, che monitori l’evoluzione dell’intelligenza artificiale nei media; servono percorsi di formazione continui per gli operatori dell’informazione, per prepararli ad affrontare le nuove sfide in modo competente e consapevole; e serve soprattutto un impegno serio e continuativo nella verifica dell’applicazione pratica dei principi enunciati nel documento.

L’appello alla trasparenza e all’accesso ai dati è senz’altro condivisibile, ed è uno dei fondamenti di un’IA etica e responsabile. Tuttavia, resta il nodo cruciale della sua effettiva applicabilità. In un contesto sempre più dominato da modelli chiusi, sistemi opachi, algoritmi proprietari e dataset inaccessibili, spesso protetti da logiche di business o segreti industriali, richiedere trasparenza può suonare più come una speranza che come una reale prospettiva. È giusto chiedere accountability ai produttori e agli sviluppatori di IA, ma non possiamo illuderci che basti invocarla per ottenerla. Servono strumenti legali, alleanze tra istituzioni e società civile, incentivi alla trasparenza, e soprattutto una nuova cultura dell’accesso ai dati che oggi, purtroppo, ancora latita nella maggior parte dei settori tecnologici e informativi.

In filigrana, tra le righe della Carta, si legge una certa paura. Un’inquietudine profonda, che nasce non tanto dai rischi tecnici o dagli usi impropri dell’IA, quanto da una sorta di spaesamento culturale. Fa paura l’idea che le macchine possano pensare, decidere, scegliere, creare. Ma di quale pensiero stiamo parlando, esattamente? Non esiste una definizione univoca, condivisa e universalmente accettata di intelligenza. Non sappiamo con certezza cosa sia davvero l’intelligenza umana, e forse non lo sapremo mai del tutto. Per questo motivo, ha poco senso aver paura dell’intelligenza delle macchine: potremmo considerarla invece un’opportunità per comprendere meglio la nostra. In fondo, è possibile che anche l’intelligenza umana sia una sorta di algoritmo biologico che ancora non conosciamo fino in fondo. In questa prospettiva, l’IA non va temuta, ma osservata con curiosità. Dovremmo accettare il fascino che deriva dal tentativo di capire meglio il cervello umano proprio attraverso le analogie, le simulazioni e i modelli che sviluppiamo per il “cervello” delle macchine.

L’IA, prima ancora di essere uno strumento, è uno specchio: ci restituisce domande su cosa significhi pensare, decidere, apprendere. E forse, proprio grazie a questo confronto, impareremo qualcosa in più anche su noi stessi.

L’approccio dell’“AI First” – partire dal presupposto che la tecnologia sia già presente, che non possiamo tornare indietro, e che dobbiamo affrontarla con lucidità e competenza – non è solo una scelta realistica: è una necessità. Pensare di rallentare il progresso con divieti e paure è un’illusione. Le paure si superano con la conoscenza, non con le censure. La proliferazione dei deepfake, ad esempio, non si contrasta soltanto con regole restrittive o filtri tecnologici: si contrasta educando all’informazione, insegnando a riconoscere i contenuti manipolati, formando cittadini digitali consapevoli, e soprattutto potenziando il pensiero critico sin dai primi gradi di istruzione.

Tra i passaggi più convincenti della Dichiarazione di Assisi c’è senz’altro l’invito a un approccio multidisciplinare. Ed è qui che il documento trova la sua maggiore forza: riconoscere che l’IA non può essere analizzata da una sola prospettiva, ma richiede l’incontro tra discipline diverse e complementari. L’IA tocca filosofia, diritto, etica, semiotica, scienza dei dati, linguistica, psicologia, sociologia, economia, giornalismo. Nessuna disciplina può bastare da sola. Il confronto è fondamentale, perché solo da un dialogo continuo tra competenze diverse può nascere una comprensione più profonda del fenomeno IA, delle sue implicazioni e delle sue potenzialità.

L’IA, se compresa e gestita correttamente, non è una minaccia, ma un moltiplicatore di possibilità, un amplificatore delle capacità umane. Come osserva il nostro Massimo Santamicone, digital strategist in NTS Project, in una recente intervista a Quattrocolonne – testata della Scuola di giornalismo radio televisivo di Perugia:

«Non è un oracolo, ma uno stagista con dei superpoteri: moltiplica le capacità umane, non le limita».

L’IA non è una mente aliena, né un’entità da temere, ma uno strumento che, se ben compreso e utilizzato, può potenziare il nostro lavoro e le nostre capacità cognitive.

Il vero compito, allora, è quello di imparare a interagire con queste tecnologie in modo critico e consapevole, senza cadere nella tentazione di opporre una visione manichea del mondo – l’umano come bene, l’artificiale come male – che non regge più. L’intelligenza artificiale non sostituisce l’intelligenza umana: la sfida è integrare le due dimensioni, in un equilibrio nuovo. Questo significa educare, formare, esplorare. E, soprattutto, accettare il fascino dell’ignoto senza cedere al timore. Perché ogni strumento, anche il più potente, riflette l’uso che decidiamo di farne., ma un moltiplicatore di possibilità, un amplificatore delle capacità umane.

«Impariamo a utilizzare bene l’I.A. anche per superare la paura. Continuando a dividere il mondo in ciò che è intelligenza artificiale e ciò che non lo è, si finisce per mettere il bene dalla parte dell’uomo, il male dalla parte dell’IA. Invece non è un oracolo, ma uno stagista con dei superpoteri: moltiplica le capacità umane, non le limita».

Un’osservazione che cerca di cogliere il senso di questo cambiamento: l’IA può aiutarci a lavorare meglio, a pensare in modo più strutturato, a esplorare dati complessi, a creare nuove forme espressive, a rendere più accessibili le conoscenze, a estendere i confini della ricerca e dell’immaginazione., un amplificatore delle capacità umane. Può aiutarci a lavorare meglio, a pensare in modo più strutturato, a esplorare dati complessi, a creare nuove forme espressive, a rendere più accessibili le conoscenze, a estendere i confini della ricerca e dell’immaginazione. Ma tutto questo può avvenire solo a patto di non fuggirla, bensì di studiarla, comprenderla, integrarla con senso critico. E soprattutto di non cedere alla tentazione di umanizzarla, attribuendole qualità e intenzioni che – almeno per ora – non ha. Perché non sarà mai l’IA a renderci disumani. Saranno, semmai, le nostre scelte, il nostro modo di usarla e il contesto etico e culturale in cui decideremo di farla agire.

Ti interessano gli argomenti trattati in questo articolo?

Se desideri saperne di più o hai domande specifiche sulle tue esigenze aziendali, il nostro team di esperti è pronto ad aiutarti.

Non esitare a contattarci per ulteriori informazioni o richieste.